咨询服务热线:400-0698-860

电话:027-5972 8168

邮箱:info@chaoqing-i.com

总部:武汉东湖高新区金融港二路9号联发科武汉研发中心2楼

北京运营中心:北京市海淀区北三环西路99号西海国际中心1号楼907(分部)

上海:上海市徐汇区龙爱路27号506(分部)

为实现AI大模型训练、科学计算等高算力需求工作,需要使用数百甚至上千个GPU 组成的计算单元作为算力基础评估、优化模型的配置和参数。为了使这样一个庞大的计算单元能够有效发挥其效率,需要使用低延迟、高带宽的网络连接各个服务器节点,以满足服务器/GPU间计算、读取存储数据的互连通信需求,同时对整个集群系统进行管理。

服务器集群的网络系统包含服务器、网卡、交换机、AOC/DAC高速线缆等主要硬件。就网络构成来看,网卡搭载于服务器内部,网卡直接与CPU相连或通过PCIe Switch与GPU相连;一层交换机通过服务器机身的端口与服务器内的网卡相连;AOC/DAC高速线缆用于实现服务器-交换机、交换机-交换机间的连接。

我们参考NVIDIA DGX系列服务器的硬件配置,重点关注网卡、机身网络端口的配置情况,分析服务器集群的网络架构发展在服务器硬件端的反映。

2016年,NVIDIA发布了搭载8颗V100的DGX-1服务器。服务器内配有4颗单端口 100Gb/s IB/以太网NIC。服务器机身有4个QSFP28端口,单端口支持100G EDR IB 网络或100G以太网络。此外,服务器机身还有2个10GBASE-T RJ45以太网端口、 以及1个10/100BASE-T IPMI网络RJ45端口。

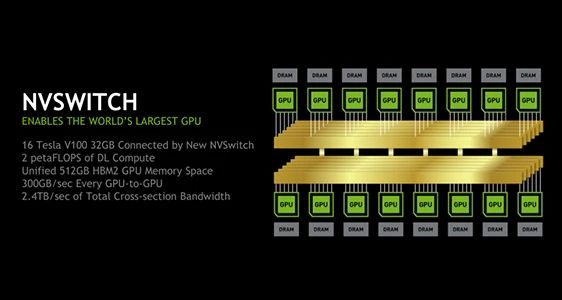

DGX-2在两块独立的GPU板卡上配备了16块Tesla V100 GPU,每块V100拥有32GB HBM2显存(共512GB),并且采用12个NVSwitch将16块GPU采用全线速互联的方式连接,使得任意两块GPU之间P2P总带宽都是300GB,处理器采用了两颗英特尔至强Platinum CPU,而存储方面则配置了1.5TB的标准内存,采用30TB的NVMe SSD,提供了更大的缓存空间,能够实现每秒2千万亿次浮点运算(2 PFLOPS),性能比DGX-1性能提高了10倍。

DGX-2有12个NVSwitch,每个GPU主板上有6个NVSwitch,将16个GPU全部互联起来,我们知道每个GPU上有6个NVLink通道,每个通道连接一个NVSwitch,所以每个GPU会和主板上的6个NVSwitch互联,每个GPU主板上有8个GPU,所以每个NVSwitch会有8个NVLink通道进来,也有8个NVLink通道出去,连接到NVBridge的背板上,也就是图中的中间桥梁部分,每个GPU主板的NVSwitch共有48个NVLink接到背板上,因此背板的总带宽是2.4T每秒。

2022年发布的DGX A800搭载了新一代Mellanox ConnectX-6网卡,单端口支持的带宽提高至200Gb/s。在DGX A800内,共有8个支持IB网络的单端口ConnectX-6网卡、 1个支持IB/以太网络的双端口ConnectX-6网卡,此外,服务器可选装1个双端口 ConnectX-6网卡。在服务器机身,共有12个QSFP端口,用于计算、存储、In-Band 管理;以及1个用于Out-of-Band管理的RJ45端口。

DGX SuperPOD上部署了多个网络,计算网络用于应用程序之间的节点间通信,单独使用存储网络来隔离存储流量。有两个以太网网络用于带内和带外管理。此外,在需求之后提供了网络设计。

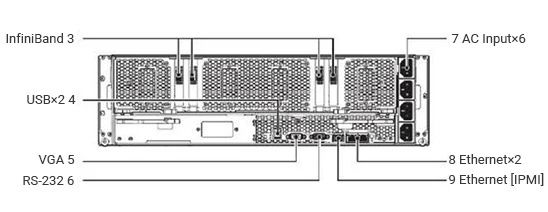

下图显示了DGX H800托盘背面的不同端口及其连接性。中间的InfiniBand计算网络端口使用双端口收发器来访问所有八个GPU。每对带内以太网管理和InfiniBand存储端口为DGX H800系统提供了并行路径,以提高性能。带外端口用于BMC访问。此外,BMC旁边还有一个额外的LAN端口,但在DGX SuperPOD中未使用。

DGX A800和DGX H800服务器内分别搭载ConnectX-6和ConnectX-7网卡。ConnectX-7相较于前者,在网络带宽、单网卡支持端口数量、PCIe适配性等方面均有提高。

参考NVIDIA服务器集群设计,集群中计算网络、存储网络均使用IB网络互联,推荐使用的服务器型号也是相同的。DGX A800和DGX H800服务器集群内IB网络推荐使用的交换机分别为Mellanox QM8790和Mellanox QM9700。Mellanox QM9700相较于前者,在单端口网络带宽、 端口数量、总吞吐量方面均有提高。

DGX A800和DGX H800服务器集群内In-Band管理网络推荐使用的交换机分别为 SN4600和SN4600C;Out-of-Band管理网络推荐使用的交换机分别为AS4610和 SN2201。

服务器-交换机、交换机-交换机间的连接主要通过AOC(Active Optical Cable,有源光缆)或DAC(Direct Attach Cable,直接连接电缆或直连铜缆)。AOC由两端的光模块和中间的多模光纤组成,信息在AOC中以光信号形式传输;DAC是两端带有固定接头的铜轴线缆组件,根据两端接头是否配有信号补偿等芯片, DAC可分为有源DAC和无源DAC;DAC中间传输的是电信号,不涉及到电到光或光到电的转换。

AOC、有源DAC、无源DAC都可以用于服务器-交换机、交换机-交换机之间的连接。三种连接方式的主要区别在于传输距离、功耗和成本。

超擎数智致力以创新的算力和网络方案,构建万物互联的数智世界。超擎数智持续为用户提供创新、高效、可靠的产品、解决方案与服务,为数据中心、高性能计算、边缘计算、人工智能等应用场景提供最优的交换机+AOC/DAC/光模块+智能网卡+DPU+GPU整体解决方案,以低成本和出色的性能大幅提高客户业务加速能力。

针对DGX 服务器集群对低延迟、高带宽、可靠性的网络需求,超擎数智提供高品质的InfiniBand HDR AOC和DAC系列产品,在降低成本和复杂性的同时,为服务器集群提供超强性能。

DGX 服务器集群架构的关键硬件需求对于实现高算力的AI训练和科学计算至关重要。不同型号的DGX 服务器配备不同的硬件组件,以满足高算力需求和网络通信要求。从服务器配置、网卡选择、交换机选型到线缆和光模块的使用,每个细节都对整个集群的性能和效率起着重要作用。

通过了解不同型号的DGX 服务器的硬件配置,我们可以更好地理解服务器集群的网络架构和发展趋势。随着技术的不断进步,新一代的网卡和交换机不断提升网络带宽和性能,为高性能计算提供更强大的支持。

公众号

电话

需求反馈