咨询服务热线:400-0698-860

电话:027-5972 8168

邮箱:info@chaoqing-i.com

总部:武汉东湖高新区金融港二路9号联发科武汉研发中心2楼

北京运营中心:北京市海淀区北三环西路99号西海国际中心1号楼907(分部)

上海:上海市徐汇区龙爱路27号506(分部)

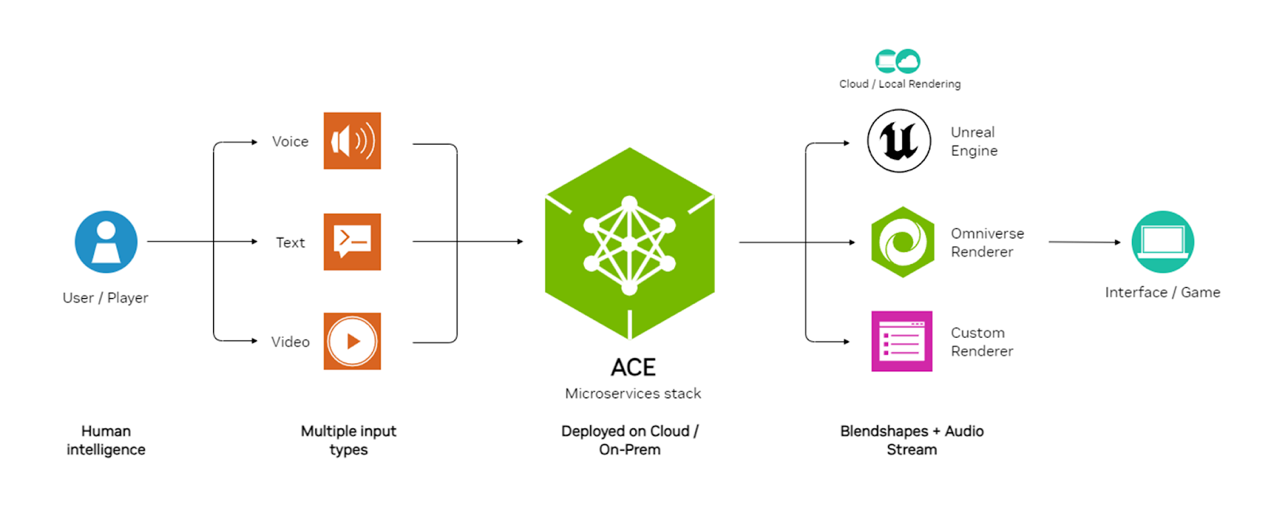

在数字化浪潮的推动下,虚拟生命的概念逐渐从科幻走向现实。NVIDIA ACE 是包含在NVIDIA AI Enterprise支持中的一套技术,可帮助开发人员利用生成式 AI 将数字人类变为现实。通过使用NVIDIA ACE,开发人员可以创建高度互动且逼真的数字人类体验。这套技术包括了自然语言处理、语音合成和计算机视觉等高级功能,这些都是创建沉浸式和引人入胜的数字化身所必需的。在NVIDIA AI Enterprise的支持下,ACE确保开发人员具备将这些高级AI功能集成到其应用程序中的工具和资源,无论这些应用程序是在云端还是本地系统上运行。

ACE的关键优势

最先进的模型和微服务

NVIDIA 预训练模型提供业界领先的质量和实时性能。

安全且一致的结果

AI 模型使用商业安全、负责任的许可数据进行训练。无论用户输入如何,微调和护栏都能实现准确、适当且切题的结果。

灵活的部署选项

搭建数字人工作流

游戏角色

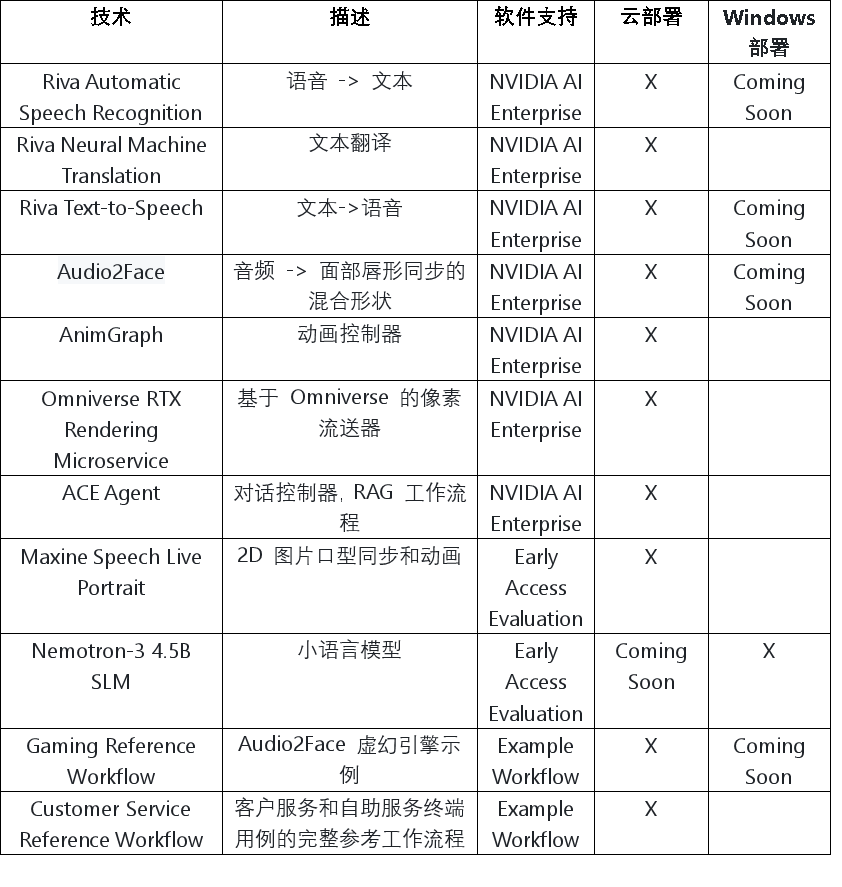

ACE目前支持的技术

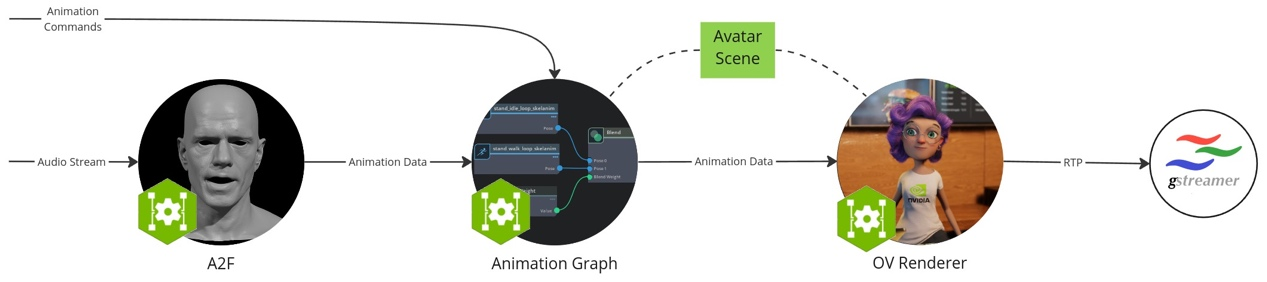

使用NVIDIA ACE搭建动画工作流的示例

在此工作流中,使用 docker 容器本地运行微服务,以创建单个头像动画流实例。

Audio2Face (A2F) 微服务:将语音音频转换为面部动画,包括口型同步

Omniverse渲染器微服务:根据加载的头像场景可视化动画数据的渲染器

数字场景:保存在本地文件夹中的 3D 场景和头像模型数据的集合

需求

已安装 Docker

有权访问公共 NGC 目录,这是下载 Avatar Configurator 所必需的

硬件:

最少一块显存大小不低于20GB的NVIDIA GPU

本次测试的平台为:超擎数智擎天系列L20 GPU服务器集群

拉取指定的Docker容器

docker pull nvcr.io/eevaigoeixww/animation/ia-animation-graph-microservice:1.0.1docker pull nvcr.io/eevaigoeixww/animation/ia-omniverse-renderer-microservice:1.0.1docker pull nvcr.io/eevaigoeixww/animation/audio2face:1.0.11

从NGC下载数字场景

ngc registry resource download-version "nvidia/ucs-ms/default-avatar-scene:1.0.0"运行动画图像微服务

docker run -it --rm --gpus all --network=host --name anim-graph-ms -v :/home/ace/asset nvcr.io/eevaigoeixww/animation/ia-animation-graph-microservice:1.0.1

运行Omniverse 渲染器微服务

docker run --env IAORMS_RTP_NEGOTIATION_HOST_MOCKING_ENABLED=true --rm --gpus all

--network=host --name renderer-ms -v

nvcr.io/eevaigoeixww/animation/ia-omniverse-renderer-microservice:1.0.1

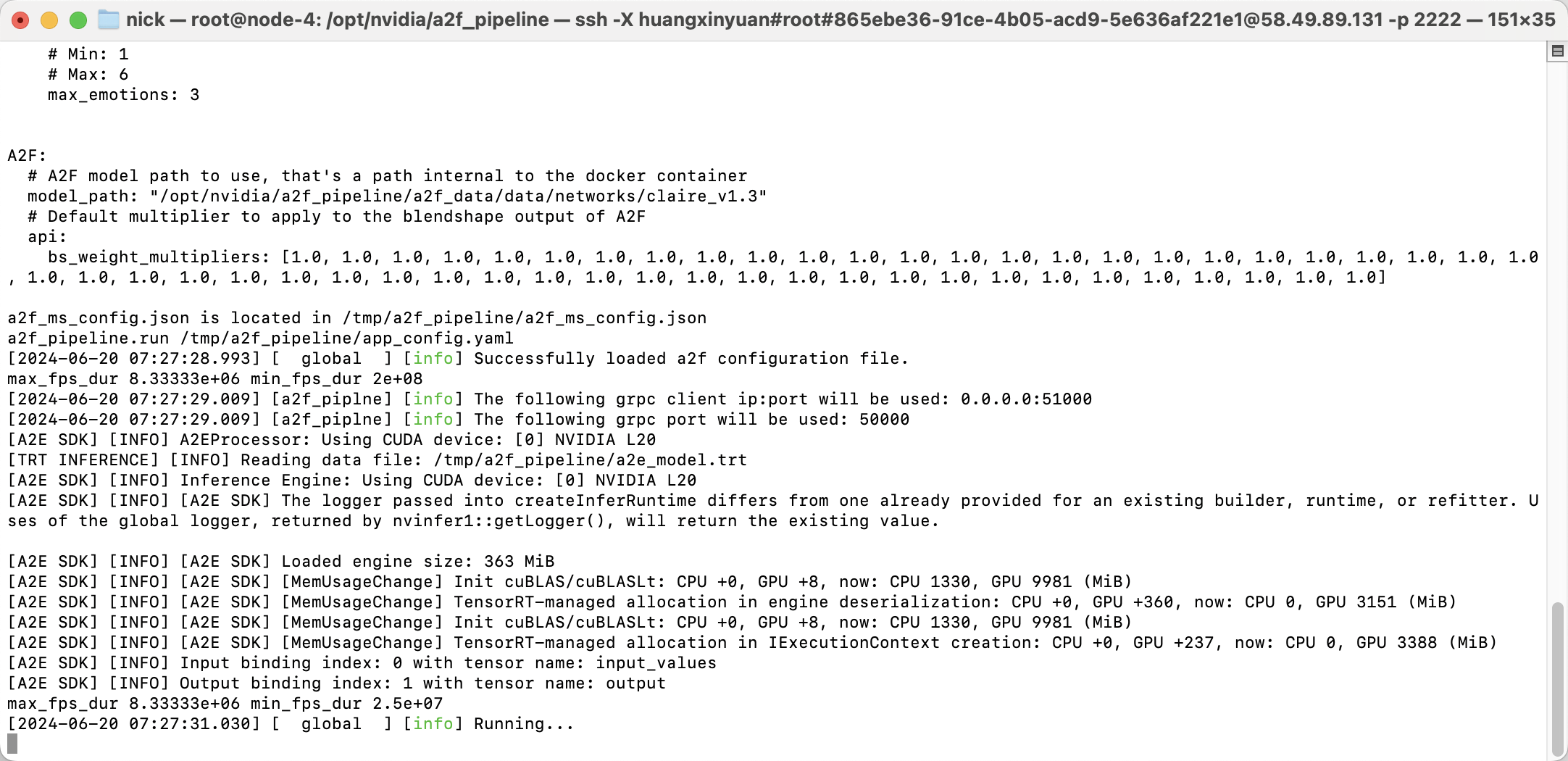

运行Audio2Face微服务

docker run --rm --network=host -it --gpus all nvcr.io/eevaigoeixww/animation/audio2face:1.0.11

生成TRT模型

./service/generate_trt_model.py built-in claire_v1.3

./service/generate_a2e_trt_model.py

启动服务

./service/launch_service.py service/a2f_config.yaml

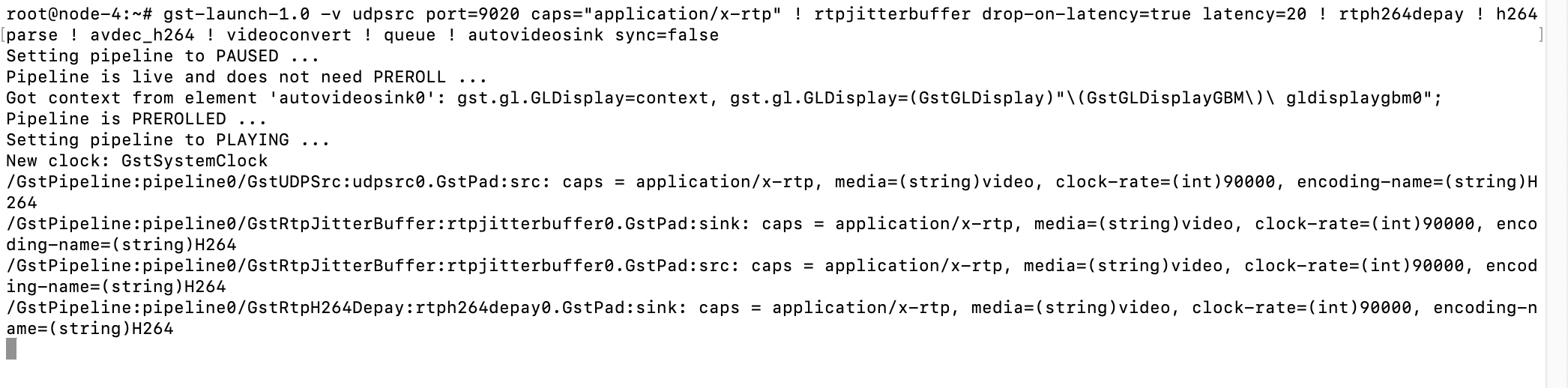

配置并启动Gstreamer

安装Gstreamer插件

sudo apt-get install gstreamer1.0-plugins-bad gstreamer1.0-libav

在终端运行视频接收器

gst-launch-1.0 -v udpsrc port=9020 caps="application/x-rtp" ! rtpjitterbuffer drop-on-latency=true

latency=20 ! rtph264depay ! h264parse ! avdec_h264 ! videoconvert ! queue ! autovideosink sync=false

在Linux中运行语音接收器

gst-launch-1.0 -v udpsrc port=9021 caps="application/x-rtp,clock-rate=16000" ! rtpjitterbuffer !

rtpL16depay ! audioconvert ! autoaudiosink sync=false

在Windows中运行语音接收器

gst-launch-1.0 -v udpsrc port=9021 caps="application/x-rtp,clock-rate=16000" ! rtpjitterbuffer !

rtpL16depay ! audioconvert ! directsoundsink sync=false

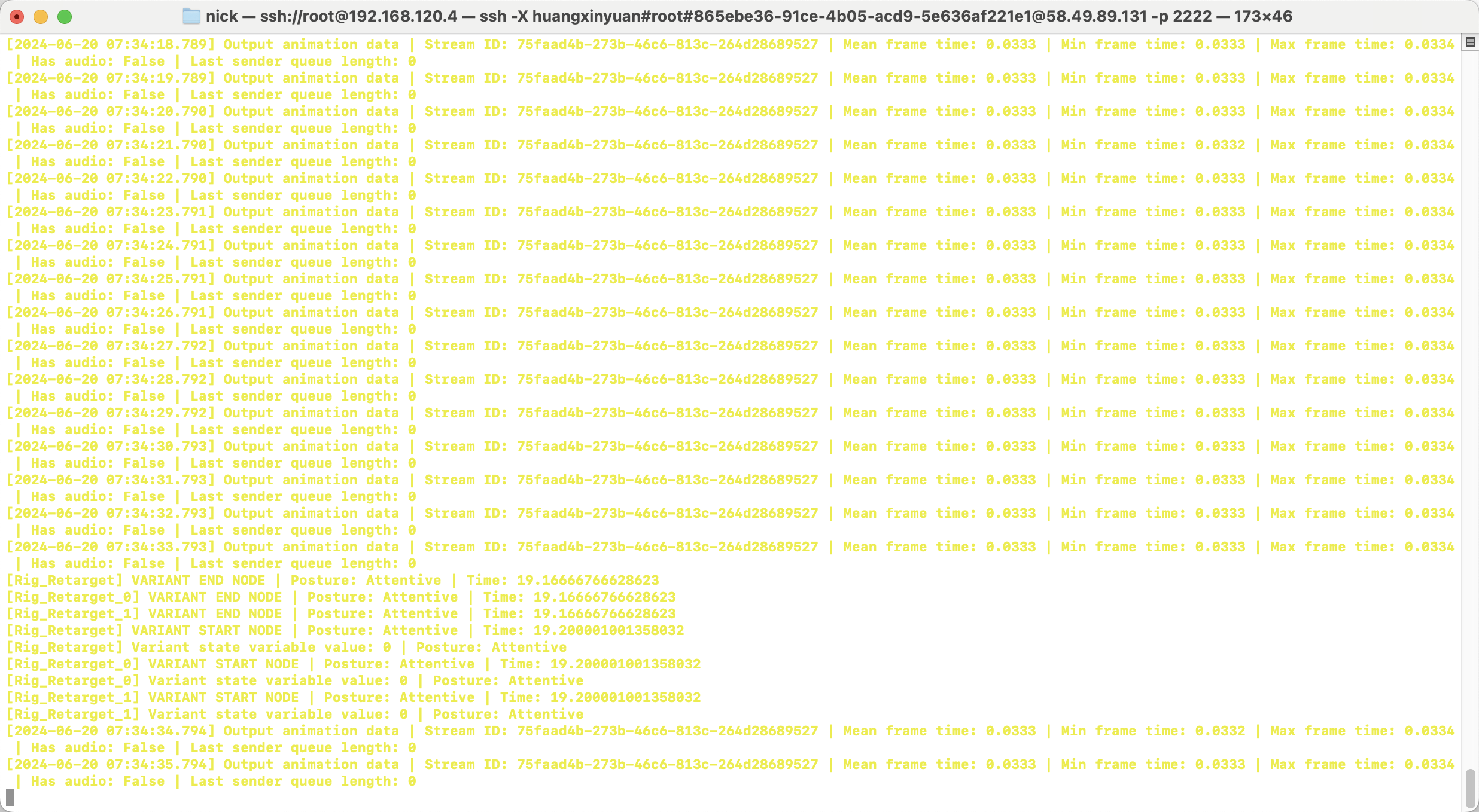

通过Stream ID连接视频及语音微服务

stream_id=$(uuidgen)

curl -X POST -s http://localhost:8020/streams/$stream_id

curl -X POST -s http://localhost:8021/streams/$stream_id

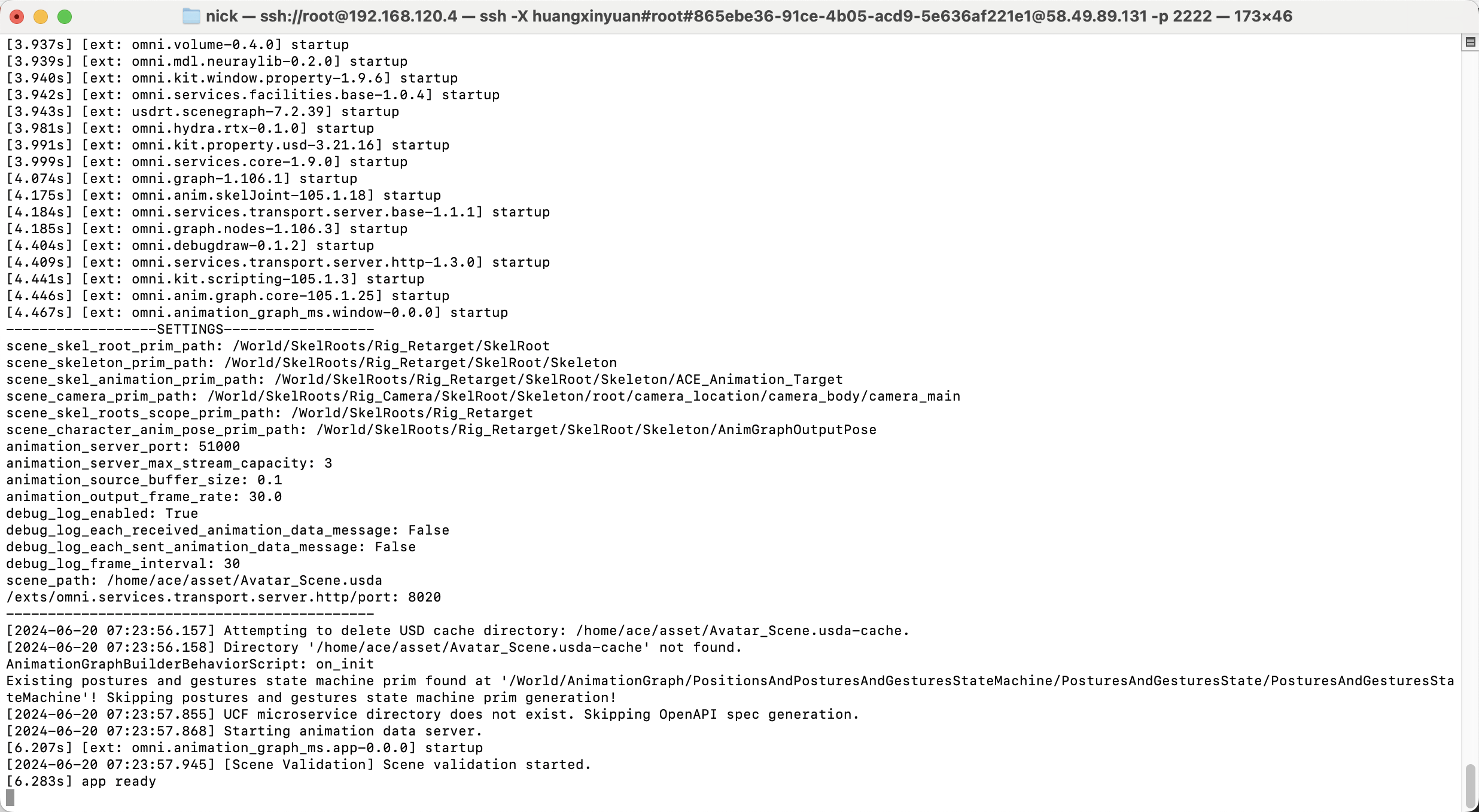

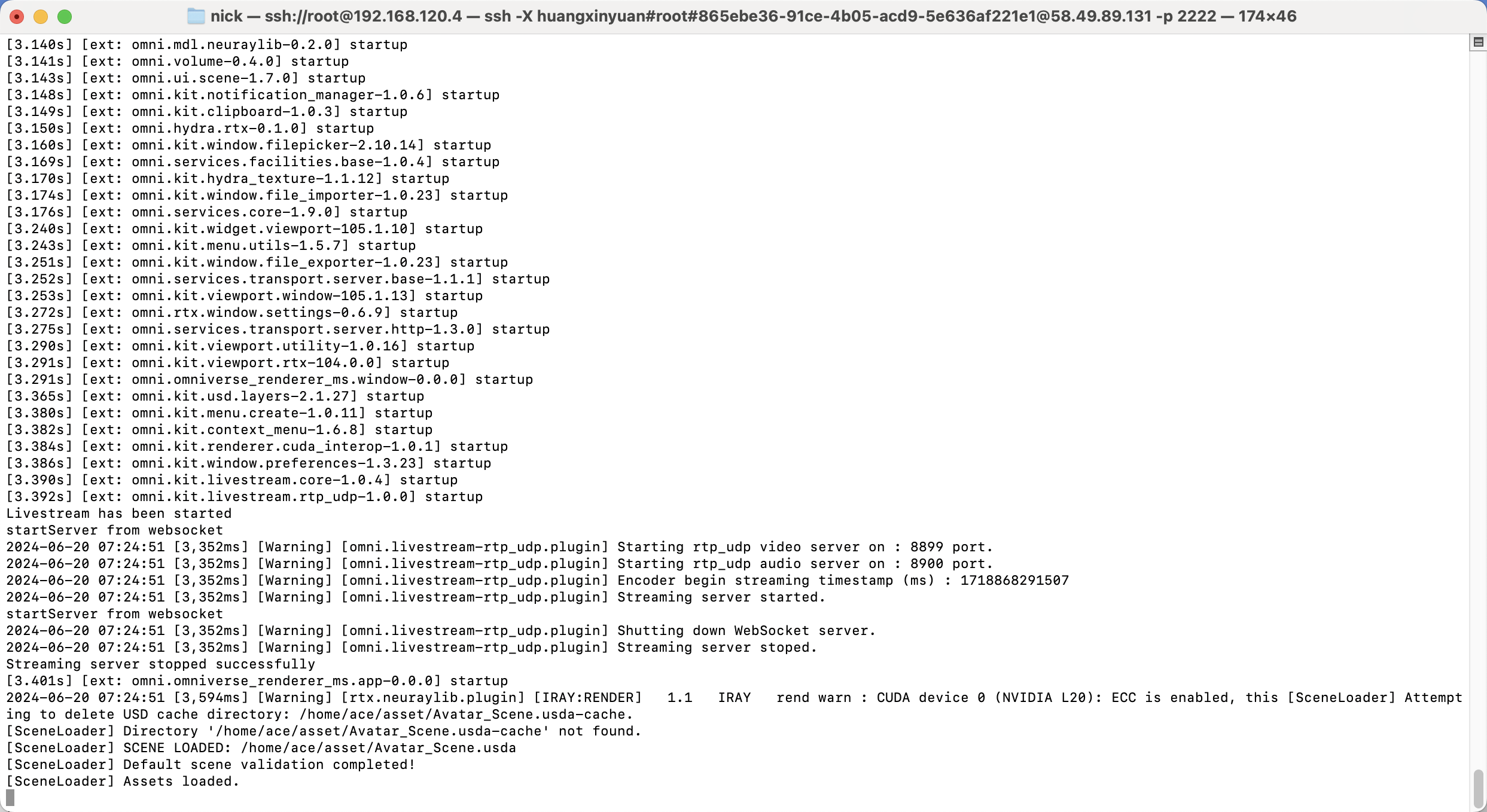

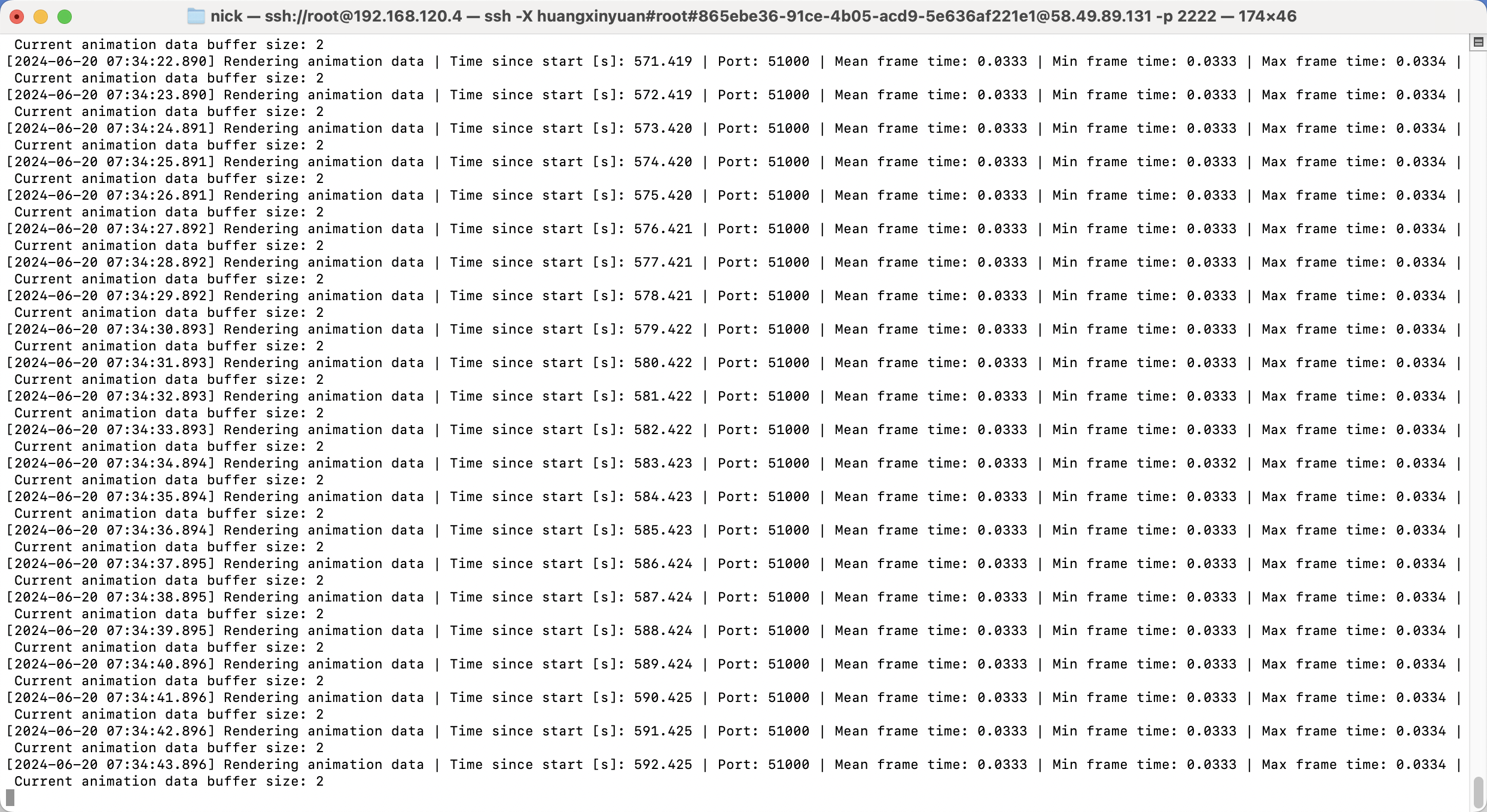

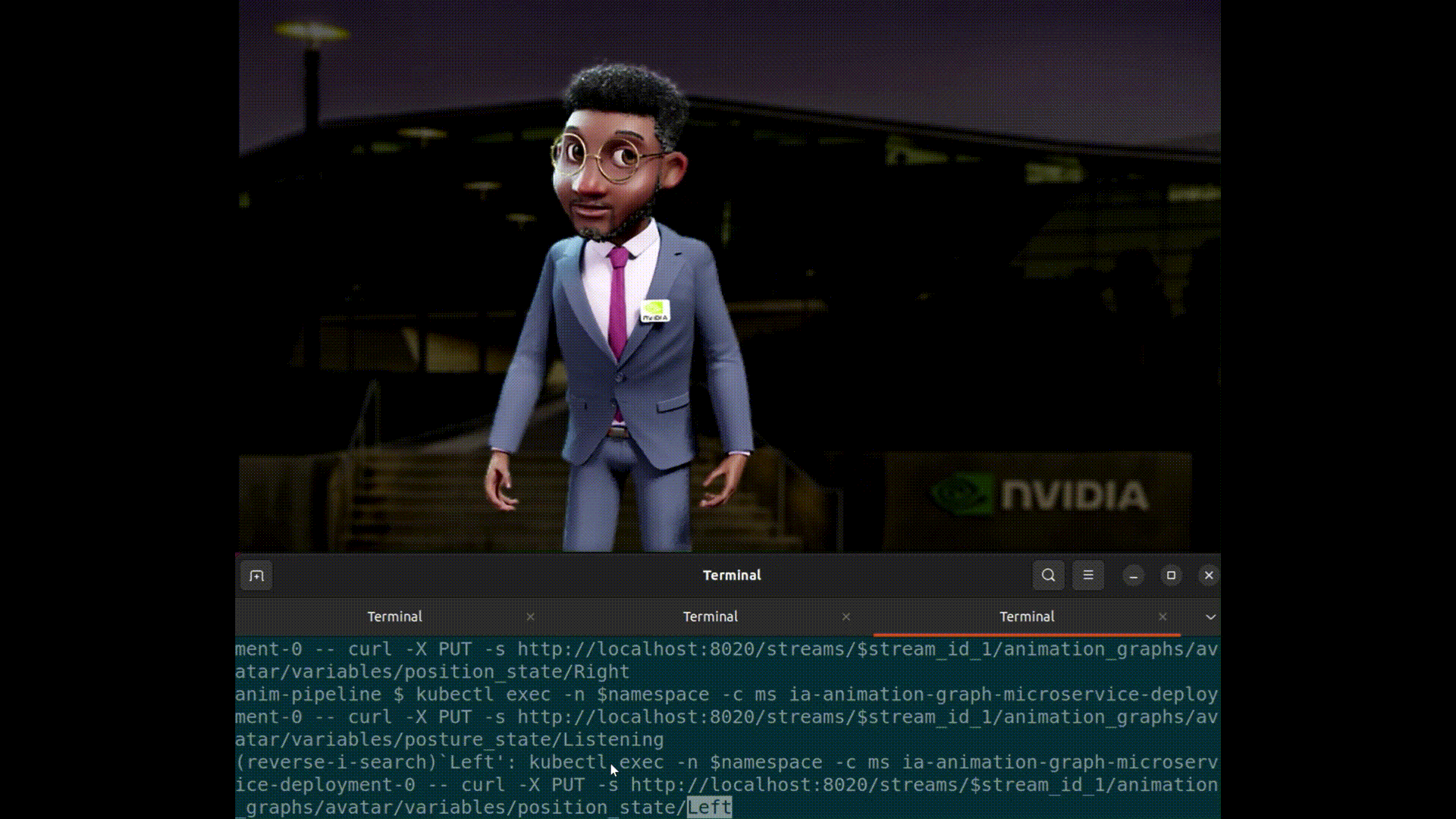

成功启动后动画图像微服务以及Omniverse 渲染器微服务运行终端将出现以下返回结果,同时可以看到动画场景弹出

测试动画图形界面

总结

可以看到通过使用ACE仅需简单几步即可快速部署一个数字人动画工作流。使用NVIDIA AI Enterprise中所支持的其他微服务你还可以给你的数字人集成更多功能,这些服务利用生成式AI的强大功能,增强数字人类的真实感和互动性,使其更加栩栩如生和具备响应能力。

NVIDIA ACE通过强大的生成式AI技术,为虚拟生命注入了无限可能。随着技术的不断发展和应用场景的扩展,ACE有望在未来进一步推动数字人类的创新和应用,使虚拟角色不仅仅是一个工具,而是一个能够与用户深度互动的“生命体”。用AI点亮虚拟生命,NVIDIA ACE正引领着这一领域迈向新的高度。

公众号

电话

需求反馈