咨询服务热线:400-0698-860

邮箱:info@chaoqing-i.com

业务中心 - 上海超擎数智科技有限公司:上海市徐汇区龙启路158号1幢灿星大厦19层1911

业务中心 - 北京超擎数智科技有限公司:北京市海淀区北三环西路99号西海国际中心1号楼907

研发中心 - 武汉超擎数智科技有限公司:武汉东湖高新区金融港二路9号联发科武汉研发中心2楼

生成式AI和大模型的兴起,算力需求爆发式上升,AI服务器凭借其强大的并行运算能力,成为支撑AI推理市场应用的核心算力基础设施。

随着DeepSeek-R1、V3满血版等千亿级超大参数模型的涌现和广泛应用,企业在部署过程中,显存、内部传输带宽和算力成为了限制推理性能的最大瓶颈,迫切需要AI服务器向更高计算密度、更强互联能力升级。

元景系列AI服务器型号为 CQ7688-L,是超擎数智推出的人工智能算力旗舰产品。元景系列AI服务器搭载 NVIDIA H20(141G)GPU,6U8卡 NVLink,是基于全新一代AI超融合架构平台,面向超大规模数据中心的强劲性能、极致扩展的人工智能服务器。6U空间内搭载1块NVIDIA Hopper架构HGX-8GPU模组,系统支持4.0Tbps网络带宽,满足大规模算力需求。

技术特色

搭载8颗 NVIDIA Hopper架构GPU,2颗Intel第四/五代至强可扩展处理器,大幅加速大模型训练速度。

散热性能极致优化,风道解耦设计提升 20% 系统能效比,12V和54V N+N 冗余电源分离供电设计,减少电源转换损耗,可选支持系统全液冷设计,液冷覆盖率高于80%,PUE<1.15。

节点内全PCle 5.0高速链路,CPU至GPU带宽提升4倍,GPU节点之间通过NVLink高速互联扩展。

全模块化设计,一机多芯兼容,灵活配置支持本地和云端部署,领先支持多样化的SuperPod解决方案。

为什么选择超擎数智元景系列AI服务器?

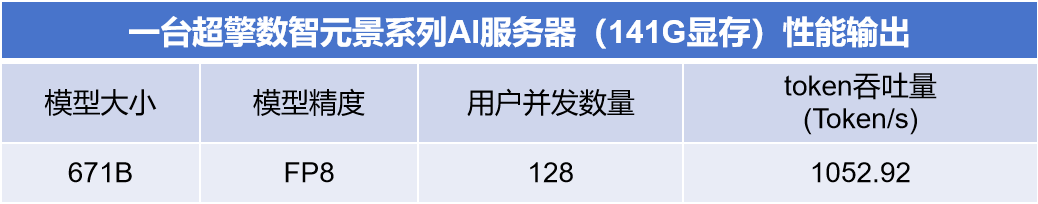

超擎数智元景系列AI服务器深度融合算力创新与产业需求,通过CUDA生态全栈兼容实现与主流AI框架无缝对接,采用算力/显存黄金配比设计实现单机部署671B大模型的高性价比突破。

突出优势

超擎数智提供专属大模型软硬一体化解决方案

超擎数智元景系列AI服务器搭载超擎自研企业级AI大模型开发平台,可搭载DeepSeek 、Qwen 、Llama3等大模型,采用软硬件一体化设计,提供“算力+平台+服务”的一站式解决方案,为用户提供快速交付、开箱即用、极致性能、安全高效的全栈大模型微调和推理的开发能力,加快DeepSeek等大模型在各行业的应用落地速度。

应用场景

AI推理

元景系列AI服务器搭载性能和功耗平衡的H20 GPU,适用于千亿级参数模型(如DeepSeek-V3/R1)等大规模推理任务,提供实时、高精度的计算能力,可以快速执行优化推理任务,有效支撑智能客服、实时决策等高并发场景。

垂类模型训练

超擎数智元景、擎天、锋锐三款多样化的AI服务器产品,满足生物医疗、金融服务、高等教育和研究、具身智能等垂类行业的模型训练或任务开发,以更高的灵活性和适应性,满足特定行业的不同算力需求,实现客户不同应用的效果和可靠性,助力垂类模型应用落地。

科学计算

搭载大容量内存、高性能处理器和GPU,能够加速数据分析和处理,加速气候模拟、物理模拟、天体物理学、蛋白分子研究等复杂计算任务,满足需要大规模数值计算和数据分析的场景。

私有化部署

针对高敏数据处理需求,提供全栈自主可控的本地化部署方案,实现数据不出域的全生命周期防护,在保障数据安全的同时实现算力资源弹性调度,提高计算效率。

超擎数智元景系列AI服务器凭借强大的GPU性能、极大的内存容量和高速存储,成功解决显存、内部传输带宽和算力等行业瓶颈,提供极致的AI性能和超高速带宽,满足大规模数据训练和推理的需求,帮助用户高效完成AI基础设施和开发环境的构建,缩短开发周期,显著提升AI开发和应用效率,是人工智能、高性能计算、图形图像处理等多种应用场景的理想选择。

公众号

电话

需求反馈